童培峰苏武等关于领域泛化的论文被第40届国际机器学习大会接收

日前,童培峰与苏武等组成的团队关于领域泛化的研究论文“Distribution Free Domain Generalization”在第40届国际机器学习大会International Conference on Machine Learning在线发表。

领域泛化(DG,Domain Generalization)是机器学习方向的一个热门问题,旨在将知识从源域转移到目标域,从而无需在训练过程中使用目标域数据。由于源数据和目标数据的分布不同,从源域训练的算法往往在目标域中表现较差,呈现出过拟合特征。

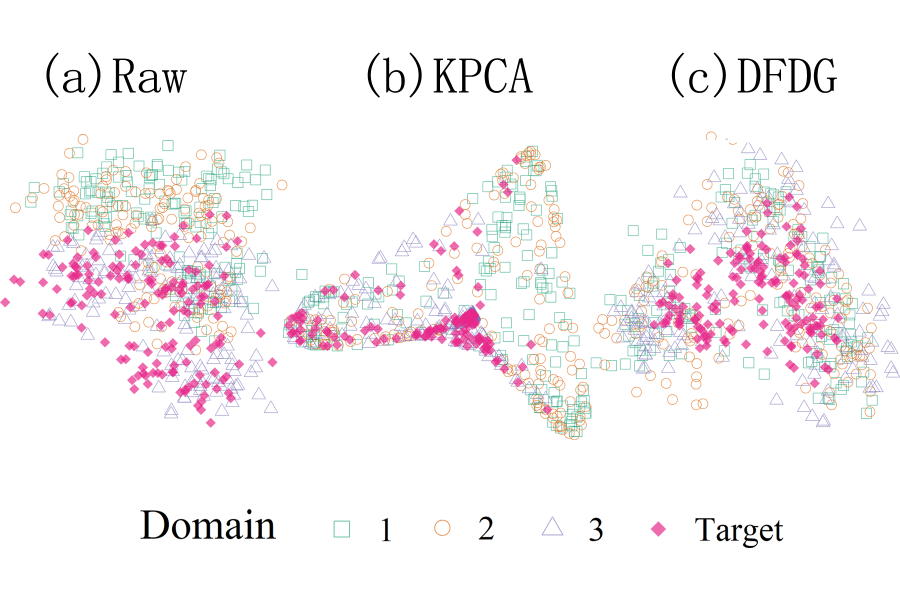

文章提出了一种用于分类的分布无关的领域泛化(DFDG,Distribution Free Domain Generalization)算法,寻找不同源域数据间的低维不变特征表示,并且通过特殊的标准化方法避免少数领域或类主导训练过程。DFDG通过基于核方法的成对两样本检验统计量刻画跨域、类差异,所选取的不变特征要求同时具有强的分类能力和小的跨领域差异。得益于引入的标准化方法,DFDG方法能使用较少的超参数提供更好的性能,允许在领域泛化过程中使用更多计算密集型分类器,并更好地适用于不平衡数据。研究还为基于核方法的领域泛化方法导出了多类分类问题的泛化界,算法在模拟实验和三个真实图像分类问题中表现了优越的性能。

领域泛化问题与DFDG算法

领域泛化问题针对具有相同分类标签但来源不同的数据集,它们通常具有不同的分布。假设不同数据集的数据分布独立同分布地取自一个共同的超分布,期望在无目标域信息的训练过程中找到跨领域的不变特征,使得算法在整个超分布上的分类效果最优。

文章使用核方法将数据映射至高维的希尔伯特再生核空间,并用MMD(maximize mean discrepancy)统计量定义同领域跨类别分布以及跨领域同类别分布的距离。算法寻找的特征位于高维再生核空间的一个低维子空间,使得跨领域距离最小、跨类别距离最大。文章还提出了两种标准化方法,分别关注成对MMD统计量的一阶矩和二阶矩信息。基于分类问题的复杂程度,可以结合KNN、SVM等分类器使用提取的低维不变特征进行分类。

图1:原始数据(a)以及采用不同算法(b:KPCA;c:DGDG)提取到的跨领域不变特征

泛化界理论

研究建立的基于DFDG的分类的泛化界理论表明,在一般的正则条件下,给定置信水平,当样本数量比分类与领域数量之积的对数以及领域数量比分类数量趋于无穷时,超额风险将趋于零。同时研究表明较大的分类数量以及较大的特征空间维数会导致更弱的控制效果。

实验结果

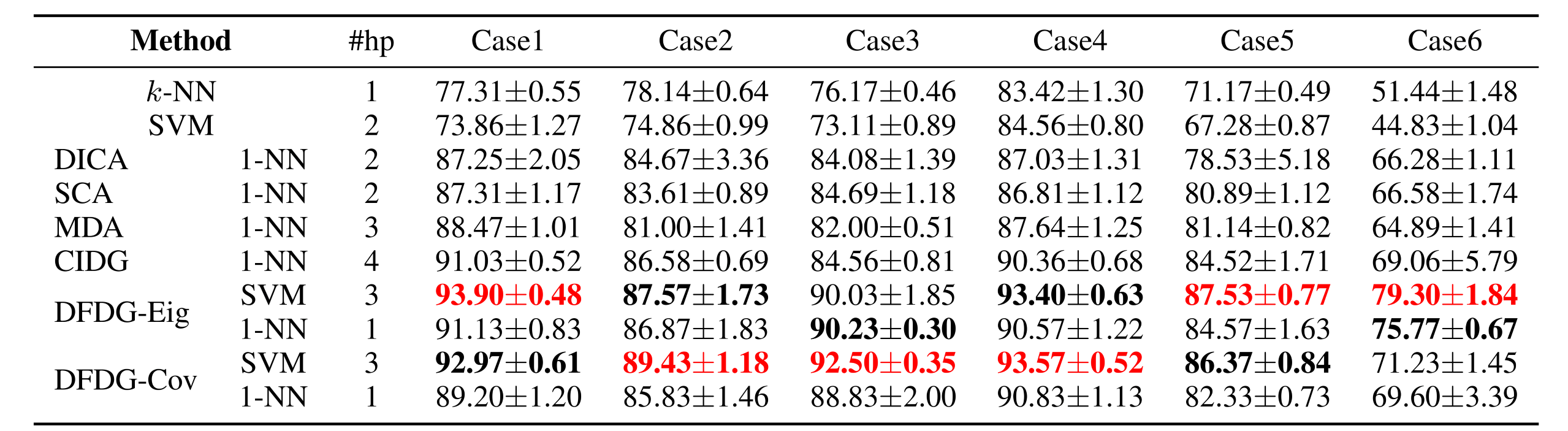

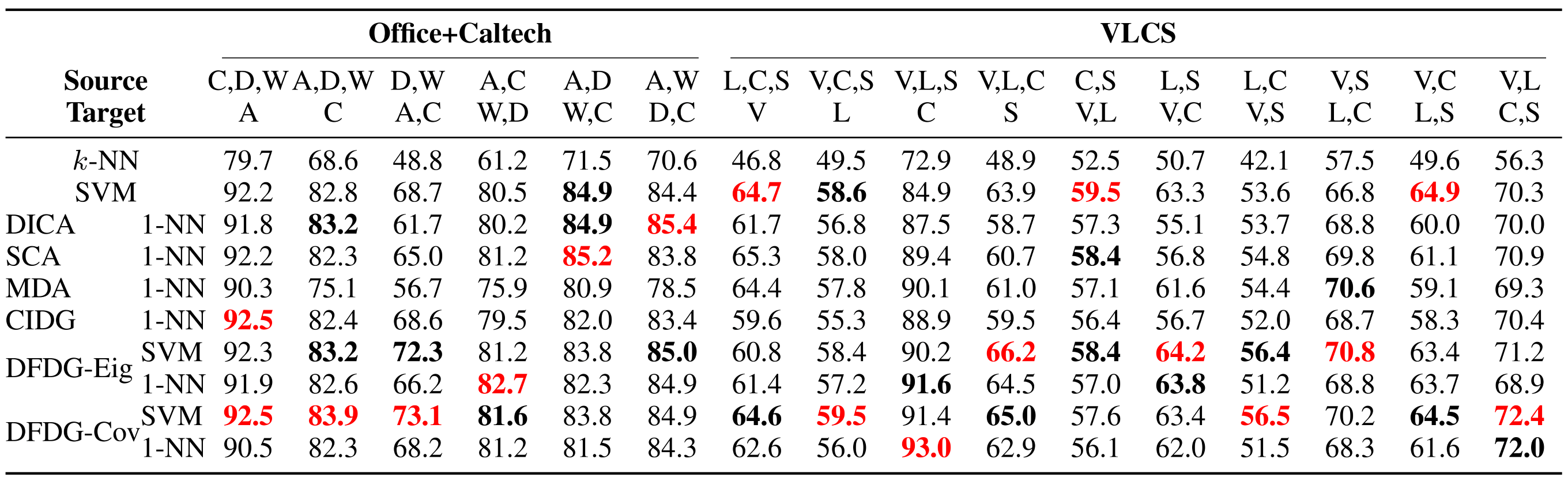

在一个模拟数据集和三个真实图像分类任务上,文章将提出的DFDG-Eig和DFDG-Cov与1-最近邻(1-NN)和支持向量机(SVM)相结合的算法与现有的算法进行比较。

研究设计了从不同的高斯分布中提取的具有4个领域和3个类别的二维数据集作为模拟数据。如表1所示, DFDG结合1-NN分类器的性能优于所有核DG方法。通过结合更复杂的SVM分类器,DFDG算法的性能得到进一步提升。

文章在案例研究中考虑了三个数据集,Office+Caltech、VLCS和Terra Incognita。对于Office+Caltech、VLCS,如表2所示,DFDG方法在16个案例中的11个取得了最佳性能, 12个获得了第二好的性能。且DFDG所需的超参数比其余核DG方法更少,在计算性能上更占优势。在不均衡数据集Terra Incognita上,表3展示了与ERM基线(神经网络方法)以及现有的内核DG方法相比,DFDG显示出更出色的性能,说明了文章提出的标准化方法在不均衡问题上的有效性。

表1:模拟数据集上分类精度的均值与标准差,其中粗体红色与黑色代表同组第一与第二优,#hp代表超参数个数

表2:Office+Caltech与VLCS数据集上分类精度的均值与标准差,其中粗体红色与黑色代表同组第一与第二优

表3:Terra Incognita数据集上分类精度的均值,其中粗体红色与黑色代表同组第一与第二优

本文的第一作者为童培峰(光华管理学院2020级博士生),其它作者是北京大学前沿交叉学科研究院2021级硕士生苏武,北京大学数学科学学院本科生李和、丁嘉麟、詹皓翔,和陈松蹊教授(通讯作者)。研究得到了国家自然科学基金项目12026607的资助。